关于空间智能(Spatial Intelligence)的一些理解

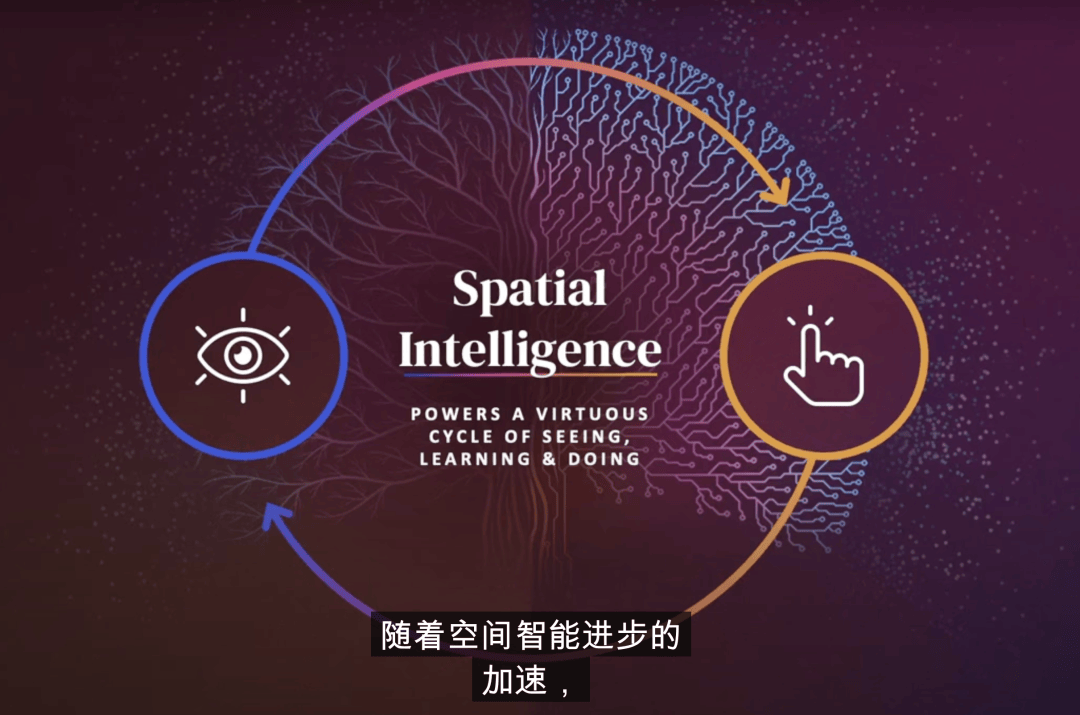

空间智能(Spatial Intelligence)

空间智能是由被称为“AI教母”的斯坦佛教授李飞飞于今年5月提出的概念,她和学生曾在参与一档播客[1]中这样定义过:”Spatial intelligence is about machine’s ability to perceive, reason, and act in 3D space and time”。

这个概念可以从我之前观察到的一个有趣现象出发来理解,我们会发现:婴儿其实不会说话,也听不懂,但是他们可以知道餐桌上的碗是用来盛饭的,沙发上放着的遥控器是用来开电视的,抽屉是可以打开的,篮球是可以扔的。而婴儿能完成这一切依赖的正是空间智能,使得人类在没有语言的情况下就能够自然地与具有物理规律的真实世界交互,理解和生成空间信息,而语言本质上只是人类定义出来的、真实世界信息的有损投影。

当前的AI大模型往往忽略了3D空间和时间(即4D),因为目前大模型底层建模上是把信息压缩成一维进行序列建模,用1D去建模世界。这种方式在文本建模中是很自然的,研究人员也通过对齐2D图像、音频等以实现多模态,它确实能够达到一定程度的智能,但始终是有限的,因为文本和2D都只是真实世界的投影。今年年初爆火的sora就是一个典型例子,仔细观察其生成的示例,会发现很多不符合客观物理规律的现象。这其实是必然的,因为sora的底层建模就没有考虑3D信息和物理规律。很明显sora被过誉了,但同时也表明了人们对于能够建模真实世界的强大AI充满着期待,而这正是空间智能想要实现的目标,也是我感兴趣的主要原因。

当AI具备空间智能后,未来将开辟许多新的场景和应用。首先,我认为空间智能一个最直接的应用领域就是——具身智能(Embodied AI)。通俗而言,具身智能结合了机器人和AI技术,使得机器人能够像人类一样理解和交互空间信息。例如,未来的家务机器人不仅能完成清洁和烹饪,还能根据家庭成员的需求调整其行为,理解不同环境下的动态任务,真正实现“机器成为人”的愿景。想象一下,一个具备空间智能的机器人能够观察到孩子在玩耍时的活动,并及时做出反应,确保孩子的安全,同时还能主动为家长提供帮助。除了对机器的赋能,空间智能还将极大增强人类的能力,尤其是在最近取得重大进展的XR领域。随着苹果和Meta等公司相继推出的新XR设备,空间智能将赋能这些设备,使虚拟与现实的界限愈加模糊。未来,用户将能够在真实世界中轻松地操控虚拟物体,进行无缝的实时互动与协作。例如在医疗培训中,医生可以通过增强现实技术进行虚拟手术模拟,实时与三维模型互动。此外,空间智能还将可能应用于游戏、自动驾驶、教育等众多领域,重塑人与技术的关系。

我们还可以进一步讨论空间智能和当前火热的LLM(大语言模型)以及多模态模型之间的关系。首先,空间智能和LLM探讨的是一个完全不一样的主题,一个关注空间信息,一个关注文本信息,两者本质上是相对独立的。至于多模态模型,和空间智能一样,本质上都旨在建模世界。具体来看,目前主流的多模态技术是以LLM、以文本为核心的,但事实上,人类不需要借助文本就能够如何理解3D物体并与其交互,表明当前的多模态模型存在局限性。再借用之前提到的婴儿的例子,婴儿饿了时不会说话,只会手舞足蹈、嚎啕大哭,这实际上也反映了单纯依赖空间智能的信息传递效率并不高。因此,我认为一个真正的通用人工智能(AGI)需要同时具备这两种能力:既能够理解和生成文本信息,也能够理解和生成空间信息,并能够与空间信息进行交互。这将可能是AGI发展的一个终极形态。

参考文献

[1] “The Future of AI is Here” — Fei-Fei Li Unveils the Next Frontier of AI